Cómo instalar los nuevos modelos gpt-oss de OpenAI en tu ordenador para tener tu propio ChatGPT en local

OpenAI ha anunciado nuevos modelos open source que cualquiera puede descargar e instalar en su ordenador: gpt-oss. Con estos ya en la calle, es una excelente oportunidad para empezar a trastear con la IA en local, es decir, ejecutada en nuestro ordenador, por lo que hoy te vamos a enseñar a instalarlos y usarlos.

Diferencias entre los dos modelos

Aunque se llamen de forma parecida, gpt-oss-120b y gpt-oss-20b no son exactamente lo mismo ni tienen los mismos requisitos. El primer modelo, gpt-oss-120b, alcanza una paridad cercana a OpenAI o4-mini y requiere de al menos 60 GB de memoria gráfica.

Tener tu propio ChatGPT en local es fácil, pero requiere de un equipo a la altura | Imagen: Xataka

Su hermano pequeño, gpt-oss-20b, es algo menos capaz (similar a o3-mini, de acuerdo a OpenAI), pero se puede ejecutar en dispositivos edge. Dicho de otra manera, se puede ejecutar en tu propio ordenador siempre que tenga al menos 16 GB de memoria, preferiblemente gráfica.

En resumen:

gpt-oss-120b: modelo grande, necesita al menos 60 GB de memoria VRAM o unidicada y no es apto para ordenadores de consumo.

gpt-oss-20b: modelo más pequeño, necesita 16 GB de memoria VRAM o unificada y es apto para ordenadores de consumo.

El que vamos a usar, por motivos evidentes, es gpt-oss-20b.

Consideraciones a tener en cuenta

Ejecutar una IA como esta en local es un proceso intensivo que puede provocar, y seguramente provoque, que tu ordenador se ralentice mucho. Aunque podrías ejecutarlo teniendo 16 GB de memoria RAM, lo ideal es que tu equipo tenga una GPU de gama alta.

¿Qué pasará si tu ordenador tiene menos de 16 GB de memoria VRAM? Que la herramienta usará la memoria RAM, cuya cifra debe ser igual o superior a 16 GB. Si no es así, el sistema no funcionará correctamente. Como recomendación general, lo ideal es dedicar todos los recursos posibles de tu ordenador a la ejecución del modelo, por lo que cierra todo lo que no sea estrictamente necesario.

Instala Ollama en tu ordenador

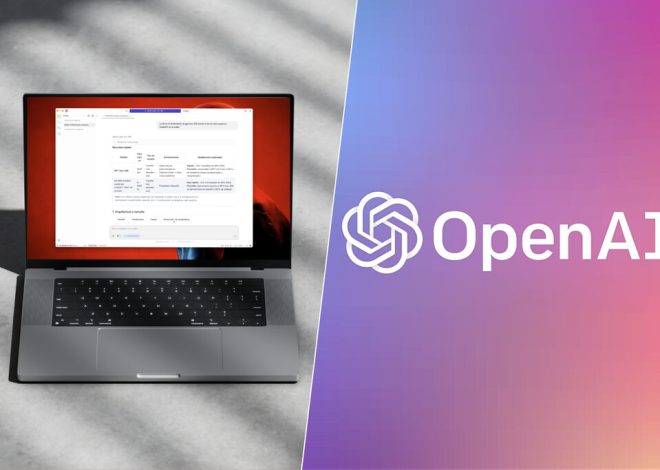

Instalación de Ollama | Imagen: Xataka

Para este tutorial vamos a usar una aplicación bastante conocida: Ollama. Es una plataforma open source que simplifica, y mucho, la instalación, acceso y uso de LLMs (Large Language Models). Digamos que es un ejecutor de modelos.

ChatGPT es una plataforma online a través de la cual interactuamos con un modelo, como GPT-4o. Ollama es lo mismo, pero en local y con los modelos que tengamos instalados en nuestro ordenador. Es un software gratuito, de código abierto y disponible para Windows, Mac y Linux.

Descarga gpt-oss

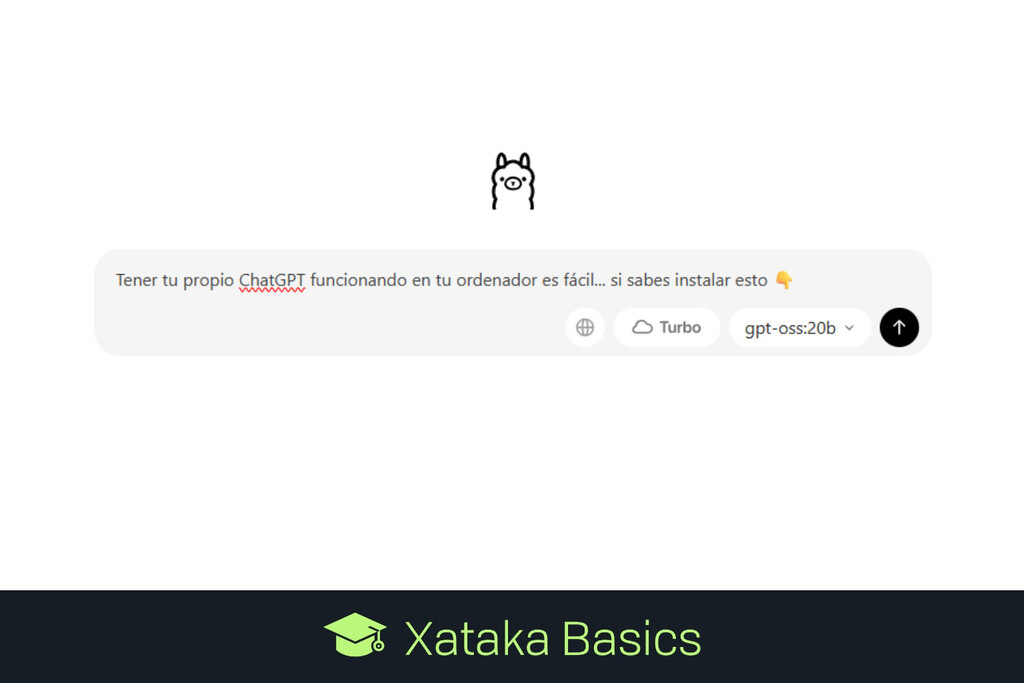

Una vez hayamos descargado e instalado el programa en nuestro ordenador nos encontraremos con una interfaz como esta. Si lo deseas, también puedes usar Ollama a la antigua mediante la interfaz de comandos, pero lo cierto es que la interfaz gráfica es mucho más agradable.

Interfaz principal de Ollama | Imagen: Xataka

Si nos fijamos, veremos un desplegable en la zona inferior derecha con el nombre del modelo que estamos usando o que, mejor dicho vamos a usar.

Acceso a los diferentes modelos de IA desde Ollama | Imagen: Xataka

Si pulsamos sobre el desplegable podremos acceder a un buen puñado de modelos, como Deepseek R1, Gemma o Qwen. Para el caso, nos interesa seleccionar «gpt-oss:20b«.

Descarga del modelo, ármate de paciencia | Imagen: Xataka

Habiendo seleccionado «gpt-oss:20b», bastará con enviar un mensaje en el chat para que comience la descarga del modelo. Ármate de paciencia, porque pesa 12,8 GB y puede llevar un rato.

Hablando con gpt-oss-20b a través de Ollama | Imagen: Xataka

Una vez esté instalado, podrás empezar a hablar con la IA como si de ChatGPT se tratara. Eso sí, si tu GPU no cumple con los requisitos mínimos verás que es muchísimo más lento que ChatGPT. No en vano, estás ejecutando el modelo en tu ordenador, no en un macrocentro de datos lleno de lo último en GPUs dedicadas de NVIDIA.

Otra opción: LM Studio

LM Studio | Imagen: Xataka

Ollama tiene la ventaja de ser intuitivo, sencillo y directo. Si queremos más opciones, un programa mucho más completo es LM Studio. Este está disponible para Windows, Linux y Mac y, como Ollama, es capaz de gestionar varios modelos, gpt-oss:20b entre ellos.

Es una aplicación más avanzada que nos permite ajustar mejor tanto el comportamiento de nuestro ordenador como el del modelo, aunque exprimirlo al máximo requiere de conocimientos más avanzados.

Imagen de portada | Xataka

En Xataka | Cómo pasar de imagen a vídeo utilizando inteligencia artificial: 14 herramientas gratis imprescindibles

–

La noticia

Cómo instalar los nuevos modelos gpt-oss de OpenAI en tu ordenador para tener tu propio ChatGPT en local

fue publicada originalmente en

Xataka

por

Jose García

.